Robert Kordts-Freudinger

Sie haben mit Ihrem Fragebogen oder Beobachtungsbogen oder mit einer anderen Erhebungsmethode quantitative Daten gesammelt! Herzlichen Glückwunsch! Nun geht es darum, diese Daten sinnvoll auszuwerten.

Die deskriptive Auswertung der Daten geschieht in der Regel nicht auf der Ebene der einzelnen Fragen (Items), sondern auf der Ebene der Skalen (oder Subtests) Ihrer Erhebung. Die folgenden Kapitel beschreiben, wie Sie diese Skalen bilden können.

- Warum Skalen bilden?

Ein Beispiel:

Sie haben 40 Schüler/innen zu ihrem Leseselbstkonzept und zu ihrer Lesemotivation mit einem Fragebogen befragt. Der Fragebogen hat 14 Items, von denen 8 das Leseselbstkonzept und 6 die Lesemotivation erfassen sollen. Die 5-stufige Antwortskala geht von ‚0‘ (trifft überhaupt nicht zu) bis ‚4‘ (trifft voll und ganz zu).

| (vermutete) Skala | Item-Nummer | Formulierung des Items |

| Leseselbstkonzept | 1 | Ich mag Lesen. |

| 2 | Ich hasse es, zu lesen. | |

| 3 | Das Lesen fällt mir immer extrem leicht. | |

| 4 | Lesen fällt mir sehr leicht. | |

| 5 | Lesefähigkeiten sind für mich später wichtig. | |

| 6 | Ich bin ein guter Leser. | |

| 7 | Mir macht Lesen Freude. | |

| 8 | … | |

| Lesemotivation | 9 | Ich habe Lust auf’s Lesen. |

| 10 | Ich habe selten Zeit, ein Buch zu lesen. | |

| 11 | Meine Eltern belohnen mich, wenn ich etwas lese. | |

| 12 | … | |

| 13 | … | |

| 14 | … |

Wie im Beitrag zu Fragebögen kurz erklärt, bilden in der Regel mehrere Items eine Skala. Dies erhöht in der Regel die Reliabilität (Zuverlässigkeit) der Erfassung (siehe unten), die eine wichtige Voraussetzung für eine hohe Validität ist. Diese Skala und damit alle dazu gehörigen Items sollen ein Merkmal erfassen. In unserem Beispiel sollen also die 8 Items zusammen das Leseselbstkonzept erfassen.

Diese Skalen sollten die folgenden Eigenschaften aufweisen (Pospeschill, 2013, S. 114):

- verschiedene Schwierigkeiten der Items: Erfassung verschiedener Ausprägungsgrade des Merkmals

- hohe Reliabilität: verlässlich und genaue Messung

- hohe Trennschärfe der Items: Differenzierung von Personen mit hoher Merkmalsausprägung von Personen mit schwacher Merkmalsausprägung

- Homogenität (Dimensionalität): Die Items der Skala erfassen nur eine Dimension des theoretischen Konstrukts

- hohe Testobjektivität: eindeutig auswertbar

- hohe Testvalidität: gute Begründung dafür, dass auch wirklich das zu erfassende Konstrukt gemessen wird.

Die alles entscheidende Frage:

Treffen diese Eigenschaften auf Ihre Skala „Leseselbstkonzept“ wirklich zu?

Mithilfe einer Skalenanalyse können Sie Antworten zu den Aspekten der Item-Schwierigkeit, Reliabilität, Trennschärfe und Dimensionalität finden. Wie, wird im Folgenden dargestellt.

Achtung: In machen Fragebögen sind einige Items negativ gepolt. Im Beispiel ist Item Nr. 2 „Ich hasse das Lesen“ anders gepolt als die anderen Items dieser Skala. Wenn die generelle Richtung der Antwortskala eine positive ist, müssen Sie das negativ gepolte Item vor allen Berechnungen umpolen, d.h. niedrige Werte dieses Items durch gespiegelt hohe Werte ersetzen usw. (4 -> 0, 3 -> 1, 2 -> 2, 1 -> 3, 0 -> 4).

- Item-Schwierigkeit

Zunächst empfehle ich Ihnen die Analyse der einzelnen Items. Hierfür bietet sich der Index der „Item-Schwierigkeit“ an. Dieser Index gibt an, von wie vielen Teilnehmenden das jeweilige Item mit hohen Werten beantwortet wird, also z.B. wie viele Teilnehmende mit „Ja“ oder „Stimme eher/voll zu“ geantwortet haben oder wie viele Teilnehmende die Multiple Choice-Aufgabe korrekt gelöst haben.

Berechnung:

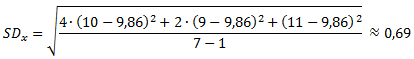

Die Schwierigkeit wird bei Ratingskalen in der Regel wie der Mittelwert (s. Deskriptive Statistik) berechnet: Man summiert die Werte dieses einen Items über alle Teilnehmenden auf und teilt diese Summe durch die Anzahl der Teilnehmenden.

Voraussetzung für die Berechnung der Schwierigkeit als Mittelwert ist, dass die niedrigste Ausprägung des Items mit ‚0‘ kodiert ist und dass die höheren Werte aufsteigend mit ‚1‘, ‚2‘, ‚3‘ etc. kodiert sind. Wie oben gesagt, sollten die Schwierigkeiten der Items, die gemeinsam eine Skala bilden, einen möglichst breiten Bereich abdecken (möglichst unterschiedlich hoch sein). Dabei sollte es nicht zu viele Items mit extremen Schwierigkeiten geben.

Anmerkung:

Im Falle eines hohen Schwierigkeits-Werts (Mittelwerts) nennt man das Item „psychometrisch schwer“, bei niedrigen Werten „psychometrisch leicht“. Im Beispiel könnten also 2 der Items für die Skala Leseselbstkonzept eine niedrige Schwierigkeit (zwischen 0 und 1) aufweisen, z.B. das Item Nr. 3 „Das Lesen fällt mir immer extrem leicht.“

Daneben könnten 4 andere Items eine mittlere Schwierigkeit aufweisen (zwischen 1 und 3) und die restlichen 2 Items könnten eine hohe Schwierigkeit aufweisen (zwischen 3 und 4), z.B. das Item Nr. 5 „Lesefähigkeiten sind für mich später wichtig.“

- Reliabilität

Da eine hohe Reliabilität wichtige Voraussetzung dafür ist, dass Sie Zusammenhänge und Unterschiede in Ihren Daten finden können, sollten Sie die Reliabilität Ihrer Skala bestimmen (s.a. Beitrag zur Planung).

Hierfür haben Sie verschiedene Rechen-Möglichkeiten. In diesem Kapitel konzentrieren wir uns auf die relativ leicht umsetzbaren Split-Half-Methode und die Methode der internen Konsistenz. Die auch möglichen Methoden Testwiederholung oder Paralleltest erklärt z.B. Bühner (2011, S. 235ff).

- a) Split-half

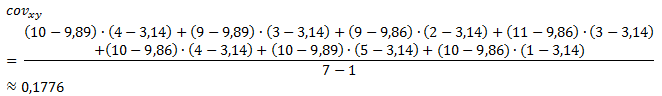

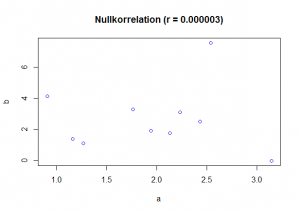

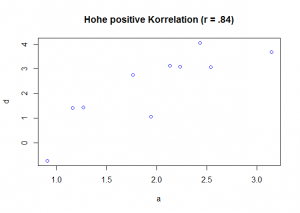

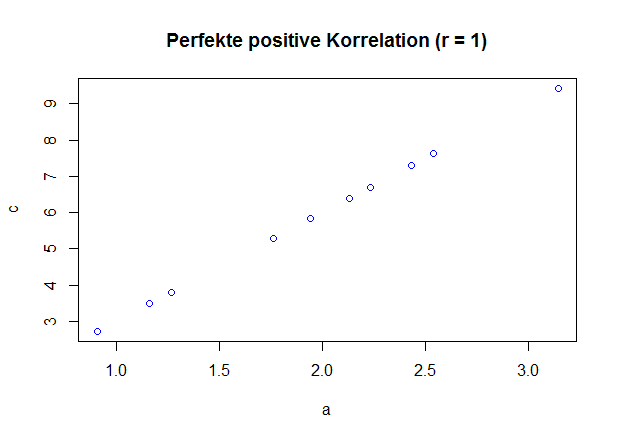

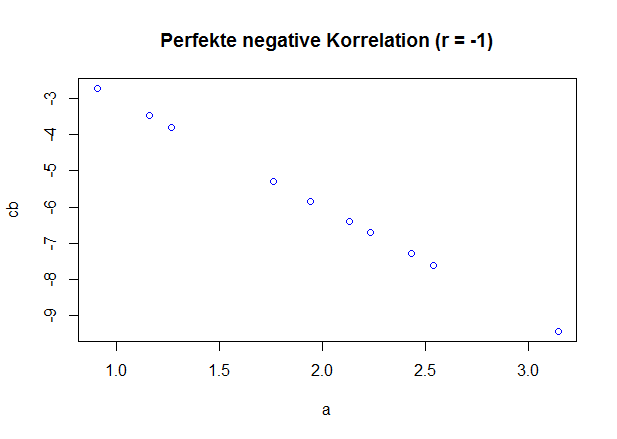

Bei dieser Rechnung wird die Skala, die Sie untersuchen, in zwei gleich große Hälften aufgeteilt und die Ergebnisse beider Hälften miteinander korreliert (in Zusammenhang gesetzt). Je höher die Korrelation zwischen beiden Hälften, desto zuverlässiger erfasst die Skala ein Konstrukt.

Achtung: WELCHES Konstrukt erfasst wird, ist hiermit noch nicht geklärt. Dies ist eine Frage der Validität.

Berechnung:

Sie können die Skala entweder nach 1. Hälfte und 2. Hälfte aufteilen oder (vor allem wenn die Skala aus sehr vielen Items besteht und die Antwortenden „ermüdet“ werden könnten) nach geraden und ungeraden Items aufteilen (sog. odd even-Methode).

Im Beispiel könnten Sie für die Skala Leseselbstkonzept eine Subskala mit allen Items mit einer ungeraden Nummer (Items Nummern 1, 3 und 5) und eine Subskala mit allen Items mit einer geraden Nummer (Items Nummern 2, 4 und 6) bilden. Die Skalenwerte dieser beiden Subskalen (z.B. Summen- oder Mittelwerte) korrelieren Sie dann miteinander. Weitere Details zum Vorgehen finden Sie z.B. bei Bühner (2011, S. 236).

- b) Interne Konsistenz

Bei dieser – am häufigsten angewendeten – Berechnung der Reliabilität werden alle einzelnen Items miteinander korreliert und der Wert dieser Korrelation als Index für die Reliabilität interpretiert. Der am häufigsten genannte Index „Cronbachs Alpha“ gibt dabei den Wert der Reliabilität an: Je höher, desto besser.

Berechnung:

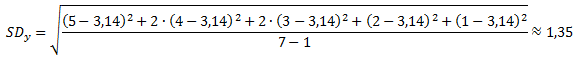

Der Kern der Formel für Cronbachs Alpha besteht aus den durchschnittlichen Korrelationen aller Items der Skala.

Generell gilt: Je mehr Items zu einer Skala gehören, desto höher Cronbachs Alpha.

Die Reliabilität sollte einen Wert von über .8 aufweisen. Ab einem Wert von .9 aufwärts spricht man von einer hohen Reliabilität (Bortz & Döring, 2006, S. 199). Alle Reliabilitäts-Werte unterhalb .7 benötigen daher einer Überarbeitung oder zumindest eines Überdenkens der Skala.

Im Beispiel könnte Cronbachs Alpha der Skala Leseselbstkonzept mit den Items in der Tabelle (siehe oben) eventuell nur einen Wert von .52 betragen. In so einem Fall können Sie versuchen, über das Weglassen einzelner Items, die wenig zum Wert beitragen, den Wert der Skala zu erhöhen (siehe Bühner, 2011).

- Trennschärfe

Die Items einer Skala sollen – bei hoher Reliabilität – Personen mit niedriger Merkmalsausprägung (z.B. Schüler/innen mit einem schwach ausgeprägten Leseselbstkonzept) von solchen unterscheiden können, die eine hohe Merkmalsausprägung aufweisen (z.B. Schüler/innen mit einem stark ausgeprägten Leseselbstkonzept). Damit dieses Kriterium erfüllt ist, müssen die Items einer Skala trennscharf sein.

Berechnung:

Die Trennschärfe eines Items berechnet sich aus der Korrelation dieses Items mit dem Wert der Skala, zu der das Item gehören soll. Je höher der Wert, desto besser repräsentiert dieses Item die Gesamt-Skala, zu der es gehört.

Die Trennschärfe sollte einen Wert von über .5 aufweisen (Bortz & Döring, 2006, S. 220). Alle Items mit Trennschärfen-Werten unterhalb .3 benötigen daher einer Überarbeitung der Skala, z.B. durch Streichen der betroffenen Items.

Im Beispiel könnte die Trennschärfe des Items Nr. 4 „Lesen fällt mir sehr leicht“ der Skala Leseselbstkonzept einen Wert von .61 betragen. Dies würde inhaltlich bedeuten, dass Schüler/innen, denen (nach Selbstaussage) das Lesen leicht fällt, auch diejenigen sind, die generell ein positives Leseselbstkonzept aufweisen (zumindest mit der Skala „Leseselbstkonzept“). Ein niedriger (positiver) Wert von .13 oder sogar negative Werte wie -.23 würden bedeuten, dass Schüler/innen, denen das Lesen leicht fällt, wahrscheinlich kein positives Leseselbstkonzept haben, da die anderen Items in dieser Skala in eine andere Richtung deuten können.

- Dimensionalität

Auch wenn die Items (z.B. Item Nr. 4 „Lesen fällt mir sehr leicht“) einer Skala (z.B. Leseselbstkonzept) mit genau dieser Skala hoch korrelieren (= eine hohe Trennschärfe aufweisen), kann es doch sein, dass sie auch mit den ANDEREN SKALEN ebenfalls hoch korrelieren (z.B. mit der Skala Lesemotivation). Alternativ könnte es auch sein, dass die Items Ihrer Skala (Leseselbstkonzept) gar nicht inhaltlich alle das Gleiche erfassen, sondern unterschiedliche Sachen. In der Regel sind diese beiden Fälle nicht erwünscht: Die Items eine Skala sollen „exklusiv“ zu dieser Skala gehören und nicht zu mehreren und pro Skala soll es nur eine inhaltliche Dimension geben. Vor allem dann, wenn eine dieser beiden Befürchtungen besteht und wenn Sie Items neu formuliert haben und bisher noch nicht empirisch getestet haben, sollten Sie deshalb eine Berechnung der Dimensionalität der Skalen vornehmen.

Hierfür wird in der Regel das statistische Verfahren der Faktorenanalyse (explorative oder konfirmatorische) durchgeführt.

Berechnung:

Die Faktorenanalyse bestimmt mittels verschiedener Verfahren die den Daten zugrundeliegenden Strukturen, die die Daten mit weniger als den ursprünglichen Items erklären können. Wenn mehrere Items das Gleiche erfassen, sollten sie auch hoch miteinander korrelieren. Die Faktorenanalyse bestimmt einen Faktor, der die gemeinsamen Anteile dieser miteinander korrelierenden Items repräsentiert (sozusagen den „Overlap“, das Gemeinsame dieser Items). Damit macht die Faktorenanalyse gleichzeitig die Struktur Ihrer Daten einfacher (weniger komplex). Ferner erhalten Sie im günstigen Fall dadurch die Bestätigung, dass den Items einer Skala (z.B. Leseselbstkonzept) wirklich nur ein gemeinsamer (in der Faktorenanalyse ermittelter) inhaltlicher Faktor zugrunde liegt. Das heißt, dass alle Items Ihrer Skala tatsächlich empirisch zusammenhängen und nicht zum Beispiel durch noch einen anderen Faktor erklärt werden können. Wenn es nur einen Faktor der Items einer Skala gibt, würden die Items Ihrer Skala „das Gleiche“ erfassen (WAS sie erfassen, das ist allerdings eine Frage der Validität!).

Details zur Faktorenanalyse inklusive aller Berechnungsschritte und Interpretationen finden Sie bei Bühner (2011, S. 295ff.).

Im Beispiel könnten Sie mittels der Faktorenanalyse aber auch herausfinden, dass – entgegen Ihrer Annahme – die ursprüngliche Skala Leseselbstkonzept tatsächlich aus zwei verschiedenen inhaltlichen Skalen besteht: der Skala „Leseselbstkonzept“ (z.B. mit dem Item Nr. 4 „Lesen fällt mir sehr leicht.“) und der Skala „Spaß am Lesen“ (z.B. mit dem Item Nr. 7 „Mir macht Lesen Freude.“). Diese beiden Dimensionen würden als „Faktoren“ oder „Komponenten“ vom Statistikprogramm ausgegeben werden. Sie würden daraufhin Ihre Skala „Leseselbstkonzept“ überarbeiten, hätten gleichzeitig aber auch eine neue Skala empirisch gefunden, mit der Sie weiterrechnen können. Mit Ihrer (neu gefundenen oder bestätigten) Skalenstruktur können Sie nun den Mittelwert (manchmal auch: die Summe) aller Items der Skala oder den Faktor aus der Faktorenanalyse als Skalenwert verwenden. Für diesen Skalenwert können Sie dann Mittelwerte und Standardabweichungen über die Antwortenden berechnen sowie andere deskriptive und inferenzstatistische Auswertungen vornehmen.

- Ein Hinweis zum Schluss

Trotz aller mathematischen Berechnungen, die Sie mit Items und Skalen durchführen können und teilweise sollten, verlieren Sie nie die Semantik, den Inhalt der Items aus dem Blick. So kann man bei den oben aufgeführten Beispielen relativ schnell schon am Inhalt sehen, dass einige Items der Skala Leseselbstkonzept ganz andere Dimensionen erfassen als eben das Leseselbstkonzept und damit niedrige Trennschärfen, Reliabilitäten etc. berechnet werden (z.B. Items 1, 2, 7). Bei anderen Items sieht man schon an der Formulierung, dass sie sehr ähnliche Dinge erfassen (empirisch: hoch miteinander korrelieren werden und damit eins davon nicht nötig ist (z.B. Items 3 und 4). Diese inhaltlichen Erwägungen sind immer ein wichtiger Bestandteil der Item- und Skalenanalysen.

Software-Empfehlungen:

Für die Berechnung der in diesem Kapitel vorgestellten statistischen Verfahren empfehlen wir die Nutzung eines Statistik-Programms wie R oder SPSS.

https://www.youtube.com/watch?v=cX532N_XLIs&list=PLqzoL9-eJTNBDdKgJgJzaQcY6OXmsXAHU&index=1

Literatur

Bortz, J. & Döring, N. (2006). Forschungsmethoden und Evaluation für Human- und Sozialwissenschaftler (4. Aufl.). Berlin: Springer.

Bühner, M. (2011). Einführung in die Test- und Fragebogenkonstruktion (3. Aufl.). München: Pearson.

Pospeschill, M. (2013). Empirische Methoden in der Psychologie. München: UTB Reinhardt.