Nachdem ich nun die fünf Aufgabenbereiche der Reihe nach abgearbeitet habe, komme ich nun zu einem Fazit und zu einer Reflexion der Digital Humanities.

Zunächst einmal lässt sich definitv festhalten, dass ich die Digital Humanities und damit auch die Digital History als sehr nützlichen Bereich ansehe. Die verschiedenen vorgestellten Programme haben mir einen tiefen Einblick in Vorgehensweisen geliefert, wie man Quellen mit der Unterstützung der Technik des 21. Jahrhunderts sinnvoll und schneller bearbeiten kann. Dabei war es zunächst sehr hilfreich einen Einblick zu bekommen, worum es sich bei der Digital Humanities überhaupt handelt. Vorher hatte ich keine große Vorstellung davon und habe es auch, um ehrlich zu sein, eher für Bereiche eines Nerds gehalten. Mein damaliger Mitbewohner, der Informatik studierte, hantierte quasi jeden Tag in der Wohnung mit Programmen herum wie die, die hier auch ihre Verwendung fanden. Gerade das Programmieren kam mir dabei immer sehr kryptisch vor. Durch die Spring School habe ich dann einen kleinen Einblick in dieses Thema erhalten. Allerdings bin ich im Rahmen dieses Blogs nicht auf das Programmieren eingegangen, weil es dann doch ein bisschen meine Fähigkeiten überstieg. Vielleicht hätte man sich in diesem Bereich noch mehr Zeit nehmen, können, denn für mich schien das Thema sehr interessant.

Das Programm Zotero fand ich sehr hilfreich bei der Erstellung von Literatur. Ich kann jedem Studenten/Studentin nur empfehlen sich ebenfalls ein solches Verzeichnis zuzulegen. Gerade wenn man am Anfang seines Studiums steht, hilft einem dies, bereits verwendete Literatur wieder zu sichten und zur Benutzung gegebenenfalls verfügbar zu machen.

Das Experimentieren mit TEI war auch sehr aufschlussreich. Zunächst hatte ich meine Schwierigkeiten mich dort hineinzufinden. Aber wenn man das Prinzip erstmal verstanden hat und sich an die standardmäßig gegebenen Regeln hält, geht es sehr schnell mit der Bearbeitung von Quellen. Wichtig bei TEI ist neben den angesprochenen Regeln dazu auch, dass man möglichst genau darauf achtet das Richtige einzutippen. Es klingt auf dem ersten Blick banal, aber es kann wirklich frustrierend sein, wenn am Rand Fehlermeldungen auftreten und man einfach nicht versteht warum. Dann neigt man dazu dem System eventuell die Schuld in die Schuhe zu schieben, wobei dieses selbstverständlich nur Befehle befolgt. Man sucht dann häufig so lange, bis man sich an die Stirn schlägt weil man lediglich einen Buchstabendreher in der Beschreibung hat oder dergleichen.

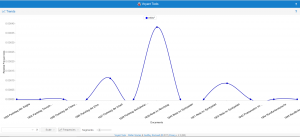

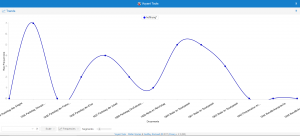

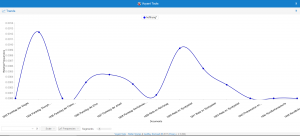

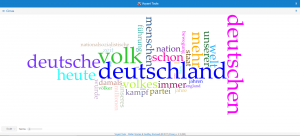

Des Weiteren war die Arbeit mit Voyant, wie in dem Blogbeitrag an sich schon angemerkt, sehr spaßig. Es macht einfach Spaß mit den verschiedenen Tools herum zu probieren und dabei immer neue Grafiken auszuprobieren. Die Neugier nach den Tools weckt den Erfindergeist und man wird erfahrener. Selbstverständlich hat Voyant auch den großen Vorteil, dass alle Diagramme auch einfach sehr schick aussehen. Gerade wenn man irgendwas präsentieren muss eignet sich Voyant also um bestimmte Ergebnisse zu visualisieren.

Der didaktische Ausblick auf das Web 2.0 war für mich als zukünftigen Lehrer natürlich von besonderer Bedeutung. Wie sich die Technik in den Jahren verbessert hat im Hinblick auf digitale Präsentationen von historischen Orten war beeindruckend. Ich denke auch gerade für die jetzige Generation fällt das Mbook auf fruchtbaren Boden. Die Möglichkeit sich Videos oder Kommentare anzusehen, wirkt auf den Schüler ganz anders, als wenn man es lediglich liest. Es werden sicherlich auch ganz andere Arten von Schülern angesprochen. Natürlich darf man dabei aber auch nicht den kritischen Blick auf diese Art der Medien verlieren. Medienkompetenz gehört auch zum Unterricht dazu, nur dass in diesem Fall nicht Medien aus historischer Perspektive beleuchtet werden müssen, wie etwa Tagebücher, sondern dass die Schüler imstande sind, sich mit den neuen Medien kritisch auseinander zu setzen, wie ebenjenem Mbook. Und zuletzt bleibt ja noch die Tatsache, dass die Klausuren immer noch in schriftlicher Form zu bewältigen sind, also darf man der Schriftlichkeit nicht ganz abschwören. Ich denke daher, dass das Mbook zunächst eine gute Ergänzung für den Unterricht darstellt. Denn es hängt nicht zuletzt vom Lehrer ab, ob die Quellen gefallen können oder nicht. Hierbei unterliegt es dann freilich den gleichen Kriterien wie seinem Vorgänger, dem klassischen Schulbuch.

Ausblick

Ein kleiner Wehrmutstropfen im positiven Sinne war, dass wir nicht länger mit MAXQDA arbeiten konnten. Dieses Programm hat wirklich meinen Neugier geweckt. Da die Lizenz für das Programm kostenpflichtig ist und dabei auch nicht ganz günstig ist, konnte ich es nicht weiter in Augenschein nehmen. Nichtsdestotrotz werde ich es im Hinterkopf behalten, denn möglicherweise könnten die Preise ja purzeln, da sich Technik dauernd ändert und MAXQDA irgendwann ersetzt werden könnte.

Was mich auch ein bisschen traurig stimmt ist, dass ich an der Ringvorlesung, die im Rahmen der Digital Humanities stattfinden, nicht teilnehmen kann. Diese findet immer zeitgleich mit meinem Kolloqium statt und sind daher außerhalb meiner Reichweite. Nichtsdestotrotz muss eigentlich viel Werbung für die Ringvorlesung und die Digital Humanities gemacht werden, da ich sie für einen wichtigen Bereich für die Zukunft halte.