Josefine Finke und ich haben für die PUZ einen Artikel über die Spring School verfasst.

Die Online-Ausgabe der Paderborner Universitätszeitschrift (WS 2017/18) findet sich hier. Der Artikel befindet sich in der Rubrik „Kurz berichtet…“.

Mein Blog zur Spring School 2017 der Universität Paderborn

Josefine Finke und ich haben für die PUZ einen Artikel über die Spring School verfasst.

Die Online-Ausgabe der Paderborner Universitätszeitschrift (WS 2017/18) findet sich hier. Der Artikel befindet sich in der Rubrik „Kurz berichtet…“.

Nach der fünftägigen Spring School war das Projekt der Erstellung einer eigenen digitalen Quellenedition noch lange nicht abgeschlossen.

Aus der Spring School „Digitale Geschichtswissenschaft“ ist die Forschungsgruppe „Urkundenwerkstatt“ hervorgegangen. Vier Studierende und drei Dozenten konvertieren vier Urkunden zur Gründung der Jesuitenuniversität Paderborn um 1600.

Die Forschungsgruppe ist in vier Teilgruppen organisiert, die jeweils eine Urkunde bearbeiten. Dieser Umstand führt dazu, dass jedes Mitglied der Gruppe sämtliche Arbeitsschritte selbstständig durchführt. Diese Vorgehensweise führt einerseits zu einer effektiven Arbeitsweise sowie andererseits zu einer Förderung der Kompetenzen der Forschungsgruppe bezüglich des Umgangs mit den eingesetzten Tools.

Bei regelmäßigen Treffen im Historischen Institut werden die Ziele stets dem aktuellen Stand des Projektes angepasst. Auch Zeit für die Diskussion von Fragen und Ideen wird bei den Treffen eingeräumt.

Ein besonderer Fokus während der Spring School lag auf der Lerneinheit TEI/XML. Mit TEI/XML ist es möglich das Fundament für eine digitale Edition zu erstellen.

Zunächst müssen wir Texte von Dokumenten unterscheiden. Texte werden durch Dokumente übermittelt. Darüber hinaus ist es möglich Texte unterschiedlich zu lesen – sie lassen Interpretationsspielräume. Mit TEI ist es möglich Informationen zum Text zu speichern. Namen oder Orte können gekennzeichnet werden, wodurch dem Text eine Struktur gegeben wird und auch Absender und Adressaten können durch bestimmte Tags kenntlich gemacht werden. Diese Auszeichnungen, sogenannte Markups, beinhaltet Interpretationen und sind niemals neutral.

Folglich lässt sich das Anfertigen einer TEI-Edition auch in den vier Arbeitsbereichen der Historischen Methode verorten, da der Quellenkorpus und sein Aussagewert, wie in der Quellenkonstitution und Quellenkritik, bestimmt werden. Aber auch der Arbeitsschritt der Interpretation spielt bei der Erstellung einer TEI-Edition eine entscheidende Rolle. Das Einfügen von Markups setzt eine detaillierte Analyse des Textes voraus, wodurch wir den Text deuten und interpretieren. Beispielsweise haben wir eine Urkunde vorliegen, bei der ein Teil des Textes durchgestrichen ist. Hier stellt sich die Frage, ob dies beabsichtigt geschehen ist bzw. wer dies durchgeführt hat. Mit Beantwortung dieser Frage und der anschließenden Auszeichnung deuten wir. Bereits diese Suche nach dem angemessenen Markup kann schon als Teil einer Forschung gesehen werden. Hier ist aber anzumerken, dass XML den Vorteil besitzt diese Unklarheiten durch bestimmte Auszeichnungen kenntlich machen zu können. Der Einsatz von Markup kann also auch dabei helfen Forschungsfragen zu beantworten und bringt den Quellenkorpus hervor.

Neben Auszeichnungen lassen sich im Header Metadaten zu den Texten speichern. Autor, Entstehungsdaten, sowie Informationen zum Format können hier eingefügt werden. Durch den Einsatz von Attributen lassen sich weitere, ausführlichere Informationen zu beispielsweise Personen oder Orten speichern.

Das Arbeiten mit TEI/XML ermöglicht es einen Quellenkorpus zusammenzustellen, zu editieren und ermöglich dadurch eine Strukturierung und historisch-kritische Analyse. Des Weiteren bietet es den Vorteil ganze Texte nach Informationen, wie Personen oder Orte zu durchsuchen und ermöglicht eine einfache Umwandlung in andere Formate wie PDF, ebook oder HTML.

Aus persönlicher Sicht habe ich die Arbeit mit TEI/XML als sehr gewinnbringend und interessant empfunden. Was an Tag 1 mit dem theoretischen Input von Peter Stadler für mich doch noch sehr abstrakt und kompliziert klang, hat sich im Laufe der Woche für mich immer mehr erschlossen. Es wurde mir zum ersten Mal tatsächlich bewusst wie viel Arbeit hinter einer digitalen Edition stecken muss, die mir persönlich bei der Erstellung von Forschungs- bzw. Hausarbeiten die Arbeit sehr erleichtert und zur Zeitersparnis geführt hat. Aber nicht nur der erste Einblick in die Arbeit mit TEI in der Spring School, sondern auch die weiterführende Arbeit an unserer Edition in den letzten Wochen hat gezeigt, wie groß der Arbeitsumfang ist. Man benötigt nicht nur Fachwissen, auch die Planung ist von entscheidender Bedeutung. Es muss sichergestellt werden, dass die Auszeichnungen einheitlich sind, um so den wissenschaftlichen Nutzen des Textes, der digitalen Edition, zu gewährleisten. Das dekodieren des Textes per Hand mit TEI/XML ist als Grundlage/Fundament zu sehen. Darauf folgen noch die Schritte der Transformation und Präsentation. Es ist mir ebenfalls bewusst geworden, wie sehr man bereits beim Erstellen des Textkorpus auf Fragen stößt bzw. vor Entscheidungen, wie man welches Phänomen behandelt/auszeichnet. Das dafür bereits eine Art Quellenkritik notwendig ist, war mir zuvor nicht klar. Trotz der sehr kleinschrittigen Arbeit bei der Auszeichnung, wird der Mehrwert für die spätere Analyse bzw. Weiterarbeit am Text deutlich.

Auch der durchaus neue Zugang zur Quelle durch TEI finde ich sehr spannend und in der Zeit der „digitalen Revolution“ als durchaus wichtig. Die Digitalisierung, damit verbunden das Erstellen von TEI-Editionen trägt dazu bei, dass Quellen besser zugänglich sind, wir eine Transparenz schaffen und es so ermöglichen, dass sich der Kreis der Rezipienten erweitert und sich so neue Zugänge zur wissenschaftlichen Arbeit/Forschung öffnen.

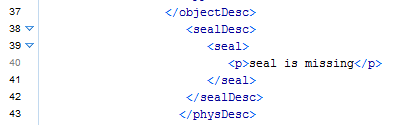

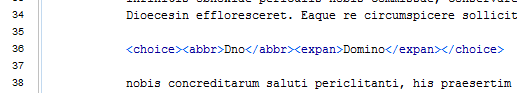

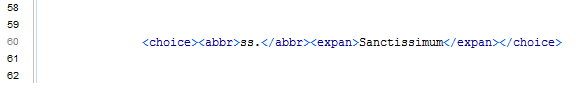

Unsere Aufgabe bestand darin die Beschreibung des Siegels, sowie das Auflösen von Abkürzungen auszuzeichnen.

Die Beschriebung des Siegels zur dritten Urkunde:

Die Auflösung von Abkürzungen aus der ersten Urkunde:

Die Spring School „Digitale Geschichtswissenschaft“ ist bereits seit einigen Monaten vorbei. Rückblickend kann ich festhalten, dass ich sehr viel aus den Tagen mitgenommen habe. Darüber hinaus möchte ich an dieser Stelle auch die gute Arbeitsatmosphäre während der Woche hervorheben. Die Dozenten haben sich sehr viel Mühe gegeben und uns Schritt für Schritt alles erklärt und auch untereinander haben wir versucht uns gegenseitig zu helfen. Das Arbeiten in dieser Gruppe hat sehr viel Spaß gemacht.

Es war sehr interessant einen Einblick in eine Disziplin, den Digital Humanities, zu bekommen, deren Bedeutung mir erst in der Woche bewusste geworden ist. Die Spring School hat es geschafft uns Einblicke in die unterschiedlichsten technischen Möglichkeiten und Werkzeuge zu geben. Insbesondere die unterschiedlichen Forschungstools kennenzulernen empfand ich als sehr hilfreich.

Obwohl ich mir nach dem ersten Input zu XML/TEI nicht vorstellen konnte, wie ich das Gehörte in die Praxis umsetzen sollte, konnte ich hier sehr schnell Fortschritte verzeichnen. Darüber hinaus ist mir bei der Arbeit an der digitalen Edition wirklich bewusst geworden, wie viel Arbeit sich dahinter verbirgt. Für mich war es immer eine Erleichterung und Zeitersparnis bei meinen Forschungs- und Hausarbeiten auf digitale Editionen zurückzugreifen. Nach den gesammelten Erfahrungen weiß ich dies doch noch etwas mehr zu schätzen.

Das kennengelernte Textanalyse Tool Voyant habe ich als sehr hilfreich empfunden. Es ermöglicht mir Texte auf unterschiedlichste Weise zu analysieren und auch einen Einsatz in meinem zweiten Studienfach Englisch kann ich mir gut vorstellen. Es lassen sich einfach wordclouds herstellen, die auch für den Unterricht einsetzbar sind. Ich kann einen Text nach bestimmten Begriffen durchsuchen und auch deren Frequenz analysieren. Voyant erlaubt es mir darüber hinaus Texte zu vergleichen, was ich mir im Fach Geschichte und Englisch mit Blick auf Reden als sehr hilfreich vorstellen kann. Ich freue mich darauf dieses Tool noch näher zu betrachten und alle der zahlreichen Möglichkeit kennenzulernen.

Als angehende Lehrerin habe ich den Blick auf den Einsatz der digitalen Medien in der Geschichtsdidaktik als sehr interessant und hilfreich empfunden. Es war hilfreich die Chancen und Probleme des Einsatzes digitaler Medien in Form eines digitalen Schulgeschichtsbuches zu diskutieren. Mir ist bewusst geworden, dass es sich immer noch um eine Herausforderung für den Geschichtsunterricht handelt und ich als Lehrkraft für einen geeigneten Einsatz digitaler Medien sorgen muss.

Auch die Lehreinheit zur Software MAXQDA empfand ich als sehr nützlich und informativ. Ich kann mir gut vorstellen MAXQDA unterstützend für eine qualitative Inhaltsanalyse zu verwendet. Denn es ermöglicht mir komplexe und umfangreiche Textsammlungen auszuwerten, indem ich Kategorien entwickle und so den Text nah relevanten Informationen filtern kann. Die zentralen Ergebnisse lassen sich auf unterschiedlicher Weise visualisieren. Ich finde MAXQDA ist eine wirklich hilfreiche Software für den Einsatz in Abschluss- und Forschungsarbeiten.

Neben den kennengelernten Forschungstools hat mich auch das Programmieren sehr fasziniert. Es hat sehr viel Spaß gemacht, da man sehr schnell Ergebnisse sehen konnte. Ich würde mich sehr gerne weiter mit ruby und dem Programmieren befassen.

Insgesamt lässt sich festhalten, dass ich aus der Spring School viele wissenswerte, interessante Aspekte zu der digitalen Geschichtswissenschaft, den Digital Humanities sowie zu hilfreichen Forschungstools mitgenommen habe. Ich denke, es ist wichtig die Bedeutung der Digitalisierung in der Geschichtswissenschaft weiterzutragen. Indem Angebote in der Universität geschaffen werden ist dies bereits in Ansätzen geschehen. Nachdem ich in der Spring School einen breiten Überblick über die Entwicklung einer digitalen Edition erhalten habe, freue ich mich darauf im Semester an unserer Edition weiterzuarbeiten und mein Wissen zu vertiefen.

Am ersten Tag der Spring School hat uns Anna Michel ebenfalls eine Einführung zum Thema Digitalisierung von Objekten des kulturellen Erbes gegeben. Bevor wir uns detailliert mit einem Projekt beschäftigt haben, sind wir der Frage nachgegangen, welchen Nutzen Digitalisate von Objekten des kulturellen Erbes aufweisen. Was ist ihr Mehrwert? Dazu haben wir unsere Ideen auf Post-Its zusammengetragen. Dabei standen vor allem Begriffe wie Zugänglichkeit, Online-Ausstellungen, Bewahrung/Archivierung, bessere Vergleichbarkeit, sowie die Nutzung für Gemeinschaftsprojekte.

Im Folgenden finden sich meine Ergebnisse zur Recherche von Informationen zu dem Projekt Nova Corbeia.

Arbeitsblatt „Digitalisierung von Objekten des kulturellen Erbes“

Aufgabe 1: Nova Corbeia – die virtuelle Bibliothek Corvey

1.)Was war das Ziel des Projekts?

2.)Welche Medien wurden innerhalb des Projektes digitalisiert?

3.) Welche Motive sprachen für eine computergestützte Umsetzung der Projektidee? Wo liegt der Mehrwert?

4.)Welche Technik kam zum Einsatz?

5.)Was fällt positiv, was negativ auf?

Aufgabe 2: Die virtuelle Ausstellung „Tausend Jahre Wissen

1.) Welchen Mehrwert bietet der virtuelle Rundgang im Vergleich zur Projektwebseite?

2.) Welche verschiedenen Medien kontextualisieren die Ausstellungsobjekte?

3.) Im Hinblick auf technologischen Fortschritt: Für wie zukunftsfähig und nachhaltig halten Sie einen virtuellen Rundgang wie „Tausend Jahre Wissen“?

4.) Welche erweiterten Funktionalitäten wären für virtuelle Ausstellungen denkbar?

Im Rahmen der Lerneinheit „Digitalisierung- Vom Scannen bis zum Urheberrecht“ haben wir uns unter anderem mit den technischen Voraussetzungen der Digitalisierung beschäftigt. Malte Rehbeins Aufsatz „Digitalisierung“ thematisiert diese und erläutert darüber hinaus die Nutzungsmöglichkeiten von Digitalisaten in den Kultur- und Geisteswissenschaften (Digital Humanities). Im Folgenden werde ich die für mich wichtigsten Aspekte des Textes zusammenfassen und herausstellen mit welchen Anwendungen und Phänomenen ich bereits gearbeitet und Erfahrungen gemacht habe.

Rehbein erklärt zunächst wichtige Begriffe, die im Zusammenhang mit Digitalisierung von Bedeutung sind. Basis der computer-gestützten Untersuchung ist ein digitales Abbild des analogen Originals. Häufig wird dieses digitale Abbild auch als Digitalisat bezeichnet. Diese Abbilder in Form von Mikrofilmen oder Reprodrucken erfüllen dann die Aufgabe des Originals als sogenanntes Surrogat. An dieser Stelle sei bereits ein Vorteil der Digitalisierung gegenüber analogen Verfahren der Reproduktion erwähnt, denn die Übertragung eines Digitalisats ist prinzipiell ohne Verluste und identisch möglich.

Handelt es sich bei dem erstellten Abbild um ein optisches wird von einer Bilddigitalisierung gesprochen. Diese Bilddigitalisierung ist laut Rehbein Voraussetzung für eine weitere Verarbeitung, denn neben den digitalen Bildern gibt es ebenfalls Verfahren, mit denen der in den Bildern transportierte Text transkribiert werden kann.

Bei der Bild- bzw. Tondigitalisierung werden optische beziehungsweise akustische Sensoren digitalisiert. Diese Formen der Digitalisierung sind für die Digital Humanities von besonderem Interesse.

Grundlagen digitaler Bilder:

Es werden zwei Möglichkeiten unterschieden Bilder als digitale Daten zu repräsentieren: Raster- und Vektorgrafiken.

In einer Rastergrafik werden die einzelnen Bildpunkte (Pixel) mit ihrer Farbtiefe in einem Koordinatensystem erfasst. Die Farbtiefe wird durch den Bitcode bestimmt. Die Farbauswahl wird größer, umso mehr Bits zur Beschreibung eines Pixels vorhanden sind. Wurden früher noch mehrheitlich schwarz/weiß Bilder bei dem Digitalisierungsverfahren erzeugt, ist die Bilddigitalisierung in Farbe heute das gängige Verfahren. Die Rastergrafik, die aus Bildgröße und Farbtiefe gebildet wird, legt auch den Speicherbedarf fest. Die Datenmengen, die bei der Digitalisierung entstehen, können enorm sein und durch die Anschaffung von Speichermedien und damit verbundene Sicherung der Daten in neue Formate sowie die Sicherstellung ihrer Zugänglichkeit zu ausgiebiger Arbeit und Kosten führen. Mit Hilfe von Bildkompression ist es möglich die Datengrößen im Speichermedium zu reduzieren. Bei der verlustbehafteten Kompression wird durch das Entfernen von als überflüssig betrachteten Informationen versucht die Menge an Daten zu verringern. Dies kann allerdings dazu führen, dass eine Verschlechterung des Bildes beispielsweise beim Vergrößern ersichtlich wird. Im Gegensatz dazu gibt es die verlustfreie Kompression, bei der keine Informationen verloren gehen, da die Daten durch Zusammenfassung von Redundanzen nur anders organisiert werden. Es ist zwar mit mehr Rechenaufwand verbunden, benötigt aber weniger Speicherplatz. Auch wenn diese verlustfrei komprimierten Bilder wieder getreu in das Original zurückgeführt werden können, ist dies nur möglich, wenn der Algorithmus gespeichert wurde und vor allem eine Software existiert, mit der die Dekomprimierung auch in Zukunft möglich ist.

Neben der zuvor beschriebenen Rastergrafik finden auch Vektorgrafiken bei Repräsentation von Bildern als digitale Daten Verwendung. Hier wird das Bild durch Zeichenroutinen, durch Informationen zur Geometrischen Form und Gestaltung, zusammengesetzt. Vektorgrafiken werden in den Digital Humanities vor allem zur Darstellung von Geoinformationen oder zwei- bzw. dreidimensionalen Modellen verwendet. Ein Vorteil der Vektorgrafiken gegenüber den Rastergrafiken ist die verlustfreie und umkehrbare Skalierung, denn die Skalierung von Rastergrafiken ist häufig mit einem Qualitätsverlust verbunden. Darüber hinaus ist in der Regel auch der Speicherbedarf der Vektorgrafiken geringer, da er unabhängig von Bildgröße und Farbtiefe ist.

Dennoch werden bei der Digitalisierung vermehrt Rasergrafiken erzeugt, da Vektorgrafiken technisch sehr komplex sind.

Verfahren der Bilddigitalisierung:

Digitalkameras und Scanner sind in den Kulturwissenschaften die meist eingesetzten Verfahren bei der Bilddigitalisierung.

Bei der Digitalkamera kann durch die Fokussierung, die Größe der Blendenöffnung, die Verschlusszeit sowie die Brennweite des Objektivs die Qualität des Bildes beeinflussen.

Scanner sind Datenerfassungsgeräte, die Objekte nach vorgegebenen Mustern oder Rastern systematisch abtasten und die aufgenommenen Signale in digitale Form umwandeln. Dabei werden verschiedene Arten von Bildscannern unterschieden. Der Flachbettscanner ist vor allem zum Scannen von zweidimensionalen Objekten geeignet. Das zu scannende Objekt wird dabei nach unten auf eine Glasplatte gelegt und durch einen beweglichen Spiegel, der das Licht auf einen fest installierten Spiegel und von da aus durch die Linse auf den Bildsensor wirft. Um ein durchgängiges scharfes Bild beim Flachbettscanner zu erhalten, muss die Vorlage flach auf der Glasplatte aufliegen. Dies gestaltet sich beim Scannen von Büchern durch die Bildung als schwierig. Daher wird speziell für die Digitalisierung von Büchern Buchscanner eingesetzt. Im Gegensatz zum Flachbettscanner verwendet der Buchscanner zwei Digitalkameras. Diese werden auf die Lichtverhältnisse und auf die Größe der Buchseiten eingestellt. Das Buch wird auf eine Buchwippe gelegt und die Seite aufgeschlagen, die eingescannt werden soll. Dann wird eine Einzel- oder Doppelseite des Buches abgelichtet. Damit Unschärfen verursacht durch Wölbungen werden durch mechanisches Fixieren oder durch eine Aufgedrückte Glasplatte vermieden. Das Weiterblättern erfolgt von Hand bzw. bei größeren Digitalisierungsprojekten durch einen Scan-Roboter, der die Seiten ansaugt und automatisch umblättert.

Analoge Verfahren sind Mikroformen, wie Mikrofiche und Mikrofilme. Hier werden stark verkleinerte analoge Abbildungen auf Filmmaterial erstellt. Aufgrund der langen Haltbarkeit des Materials werden diese Verfahren vor allem zur Langzeitarchivierung eingesetzt.

Parameter:

Die technischen Parameter der Digitalisierung bestimmen die Aussagekraft eines Digitalisats und dessen Verwendbarkeit. Bei der Nutzung von digitalen Daten ist es unabdingbar die Parameter ihrer Entstehung zu kennen und auch kritisch zu prüfen, ob bzw. wie die Daten für den Forschungszweck geeignet sind.

Erschließung der Digitalisate:

Bei der Erschließung von Digitalisaten spielen Metadaten eine wichtige Rolle, da sie unter anderem die Auffindbarkeit der Objekte ermöglichen. Rehbein unterscheidet dabei vier Typen von Metadaten, die für die Nutzung von Bilddigitalisaten von Bedeutung sind: technische, deskriptive, strukturelle und administrative Metadaten. Dabei handelt es sich zwar um klar definierte Kategorien, aber sie können parallel angewendet werden. Für die jeweiligen Fachbereiche gibt es darüber hinaus weitere Standards und Spezifikationen. Zu den international gängigen Metadaten-Standards im Bereich der Digitalisierung des kulturellen Erbes zählt das uns vorgestellte TEI. Die Richtlinien und XML-Schemata ermöglichen eine Kodierung elektronischer Texte,

Textdigitalisierung:

Soll beispielsweise ein Buch digitalisiert werden reicht es nicht aus nur die geometrischen Positionen der einzelnen Pixel in einer Rastergrafik zu speichern. Der Text muss in einem weiteren Bearbeitungsschritt aus der Rastergrafik extrahiert werden und daraus Zeichencodes generieren. Zur Texterfassung, Transkription, können zwei Verfahren angewendet werdet. Zum einen kann bei der manuellen Texterfassung durch Abtippen der Vorlage per Hand der Text erfasst werden. Dabei besteht allerdings die Gefahr von Lese- und Flüchtigkeitsfehlern sowie Interpretationsunterschiede bei schlecht lesbarer Handschrift. Dieser Problematik kann entgegengewirkt werden, indem zwei Personen unabhängig voneinander den gleichen Text transkribieren und anschließend durch einen Dritten verglichen werden. Zum anderen kann das Verfahren der automatischen Texterfassung, Optical Character Recognition (OCR) angewendet werden. Dieses Verfahren der Texterkennung lässt sich in drei Phasen gliedern. Bei der Vorverarbeitung wird die Rastergrafik optimiert, um Verzerrungen und Rotationen der Vorlage auszugleichen. Darauf folgt die eigentliche Zeichenerkennung, die Binarisierung. Als letzten Schritt schließt sich die Nachbereitung an, um die Qualität des erkannten Textes zu optimieren.

Maßgeblich für die Qualität der Texterkennung ist die Erkennungsgenauigkeit. Diese entscheidet darüber, ob und wie brauchbar ein erfasster Text ist. Die Erkennungsgenauigkeit ist von der Qualität der Vorlage abhängig. Ein moderner Buchdruck erreicht also eine höhere Genauigkeit als beispielsweise eine Faktur aus dem 19. Jahrhundert.

Weitere Digitalisierungsverfahren:

Neben der zuvor beschriebenen zweidimensionalen Bilddigitalisierung und damit verbundenen Texterfassung gibt es noch weitere Verfahren der Digitalisierung. Insbesondere die dreidimensionale Objektdigitalisierung gewinnt immer mehr an Bedeutung. Geht bei dem zweidimensionalen Verfahren Eigenschaften, wie Wölbungen; Gravuren, Beschaffenheit des Bucheinbandes verloren, können sie mit Hilfe des 3D-Modelss dargestellt werden. Neben visuellen Verfahren zur Digitalisierung gibt es auch Verfahren aus dem nicht visuellen Bereich, wie die Audiodigitalisierung.

Während meines Studiums habe ich bereits ein paar Erfahrungen mit Digitalisierung gesammelt. Im Rahmen meiner wissenschaftlichen Arbeiten habe ich sowohl Flachbettscanner als auch Buchscanner verwendet. Darüber hinaus ist es mir auch möglich auf Digitalisate zuzugreifen. Dadurch ist mir die Bedeutung und Wichtigkeit von Digitalisierungen besonders deutlich geworden. Gerade im universitären Kontext ist es eine enorme Erleichterung und Zeitersparnis auf Digitalisate zugreifen zu können. Obwohl die Frage nach der Nachhaltigen Nutzung der Digitalisate immer noch diskutiert wird, haben meines Erachtens Digitalisate viele Vorteile. In der Spring School 2017 konnte ich weitere Erfahrungen sammeln und einen genaueren Einblick in die technische Verfahren der Digitalisierung bekommen.

Zum Beginn der Spring School hielt Anna Michel einen einführenden Vortrag zur Entstehungsgeschichte der Digital Humanities. Der technische Fortschritt hat über die letzten 20 Jahre zu Veränderungen in allen Bereichen des Lebens geführt. An diesem Prozess der „digitalen Revolution“, der technischen Ausweitung im Alltag, der weltweiten Vernetzung, ist auch die Wissenschaft beteiligt.

Wir erhielten einen Einblick in den Forschungsbereich der Digital Humanities – die Entwicklung und Anwendung aktueller Technologien, die den wissenschaftlichen Erkenntnisprozess, die Arbeit in den Geisteswissenschaften erleichtern soll. Die Person Roberto Busa wurde dabei hervorgehoben. Er gilt als Begründer, als Pionier, der Anwendung der neuen Computertechnik für die Geisteswissenschaften.

In ihrem Werk Computation and the Humanities beschäftigen sich Julianne Nyhan und Andrew Flinn mit der Entstehung derDigital Humanities und ihrem Projekt „Hidden Histories“. Dies wird hier kurz anhand von Leitfragen vorgestellt.

Arbeitsblatt „Entstehungsgeschichte der Digital Humanities“ –

Projekt: „Hidden Histories“ (Text von Julianne Nyhan und Andrew Flinn)

1.)Welche Gründe nennen die Autoren, die die Erforschungsgeschichte der DH erschweren?

2.)Wo befinden sich historische Quellen zu Projekten der DH?

3.)Mit welcher Art von Archivalien ist der Historiker konfrontiert?

4.)Welche Methode wählen die Autorinnen, um Erkenntnisse zur Geschichte der Digital Humanities zu gewinnen?