Bei dem folgenden Text handelt es sich um eine Zusammenfassung der wichtigsten Informationen aus Rehbein, Malte: Digitalisierung. In: Fotis Jannidis, Hubertus Kohle und Malte Rehbein (Hgg.): Digital Humanities. Eine Einführung. Stuttgart 2017, S. 179-198. Der Aufsatz bietet einen ersten Überblick über verschiedene Verfahren und Fachbegriffe der Bilddigitalisierung.

Der von Rehbein verfasste Text handelt von der Digitalisierung analoger Originale, insbesondere der Bilddigitalisierung. Hierbei werden zunächst die Vorteile der neuen Bilddigitalisierung vorgestellt. Die früheren Abbildungen hatten etwa noch den Nachteil, dass sie durch ihre physische Form in ihrer Zugänglichkeit eingeschränkt waren und weitere Kopien Kosten und gegebenenfalls Informationsverlust zur Folge hat. Dies ist bei der Bilddigitalisierung nicht der Fall, denn besonders die computergestützte Vernetzung bietet, im Vergleich mit der Arbeit am Original, neue Zugangsmöglichkeiten. Auch ist die Anfertigung weiterer Kopien kostengünstiger und verlustfrei möglich. Im Weiteren werden die Begriffe „Auflösung“ und „Abtastrate“ im Rahmen der Analog-Digital-Wandler, welche mittels Sensoren ein Objekt messen und die Messdaten speichern, eingeführt. Darauf aufbauend werden in ausführlicher Form zwei Möglichkeiten unterschieden, unsere Bilder in digitaler Form zu repräsentieren: die Raster- und die Vektorgrafik. Dieser Abschnitt ist m.E. von hoher Bedeutung, denn die beiden Möglichkeiten haben für uns als Historiker jeweils entscheidende Vor- und Nachteile. Bei einer Rastergrafik wird das Bild in ein zweidimensionales Koordinatensystem eingeteilt, wobei jeder Punkt in diesem Koordinatensystem mit einem Wert versehen wird, welcher den jeweiligen Farbwert angibt. Rastergrafiken können anhand ihrer Bildgröße und ihrer Farbtiefe unterschieden werden. Die Bildgröße wird durch die Anzahl der Punkte im Koordinatensystem bestimmt, wobei dieser Wert entweder in einer Spalten-mal-Zeilen-Form oder in einer Multiplikation dieser dargestellt werden kann. Die Farbtiefe beschreibt, wie viele verschiedene Helligkeits- und Farbwerte von einem Bildpunkt im Koordinatensystem, also von einem Pixel, angenommen werden können. Ein Bild mit einer Farbtiefe von 1 kann nur die Werte schwarz und weiß annehmen. Auch bei Schwarz-weiß-Bildern gibt es jedoch die Möglichkeit, das Bild weiter in Graustufen auszudifferenzieren; ein Bild mit einer Farbtiefe von 8 Bit hätte z.B. 256 verschiedene Graustufen, trotzdem hätte es nur einen Farbkanal. Moderne ist jedoch die Digitalisierung in Farbe, wobei das RGB-Farbmodell vorgestellt wird. Hierbei wird jeder Bildpunkt mit drei Werten versehen, die jeweils für die Grundfarben Rot, Grün und Blau stehen. Der Bildpunkt nimmt nun neue Farben an, indem die Grundfarben in verschiedenen Abstufungen miteinander vermischt werden. Dadurch, dass es sich um drei Farbkanäle handelt, sind bei einer Farbtiefe von 8 Bit pro Kanal bereits 16.277.216 verschiedene Farbwerte möglich. Der Anstieg der Bildgröße und Farbtiefe ist jedoch auch mit einem Anstieg der Datenmengen und einem daraus resultierenden Kostenanstieg verbunden, weswegen in das Thema der Bildkompression eingeführt wird. Hierbei wird zwischen verlustfreier und verlustbehafteter Kompression unterschieden. Bei der verlustbehafteten Kompression wird auf Informationen verzichtet, die als überflüssig betrachtet wird, dies hängt jedoch ganz vom Verwendungszweck ab. Ein Beispiel für ein verlustbehaftetes Bildformat wäre JPG. Die verlustfreie Kompression hingegen speichert hingegen Informationen über die Muster und Flächen eines Bildes, anstatt jeden einzelnen Pixel. Durch einen Algorithmus ist dies verlustfrei möglich, jedoch sollte dieser offengelegt werden. Ein Beispiel für ein verlustfreies Bildformat wäre TIFF. Eine weitere Möglichkeit, neben der Rastergrafik, Bilder in digitaler Form zu präsentieren, ist die Vektorgrafik. Die Vektorgrafik beschreibt nicht jeden Bildpunkt einzeln, sondern versucht das Bild in seinem Aufbau zu erfassen und diesem sogenannte grafische Primitive (Punkte, Linien, Formen, Farbe etc.) zuzuordnen. Vektor- und Rastergrafik unterscheiden sich voneinander stark, was zu jeweiligen Vor- und Nachteilen führt. Ein wesentlicher Unterschied liegt in den Möglichkeiten der Skalierung. Ist eine Skalierung bei einer Rastergrafik nur mit einer Veränderung der Bildpunktanzahl möglich, was zu Qualitätsverlust führen kann, so werden die grafischen Primitiven einer Vektorgrafik lediglich verlustfrei und umkehrbar an die neue Größe angepasst. Der Speicherbedarf ist bei einer Rastergrafik abhängig von Bildgröße und Farbtiefe, der einer Vektorgrafik von ihrer jeweiligen Komplexität. Der Speicherbedarf einer Rastergrafik ist also kalkulierbarer. Hinzu kommt, dass für die Darstellung einer Vektorgrafik auf dem Bildschirm ein gewisser Rechenaufwand erforderlich ist. Weitere Vorteile einer Vektorgrafik liegen vor allem in der einfachen Umwandlung in eine Rastergrafik, dies ist anders herum schwieriger, und in der Bildbearbeitung.

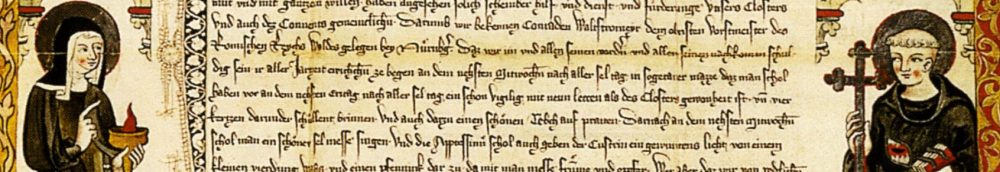

Bei der Bilddigitalisierung, also der Messung von Licht, welches von einem Objekt reflektiert wird, werden zwei Instrumente unterschieden: Digitalkameras und Scanner. Als analoge Alternative besitzen die Mikroformen eine hohe Relevanz. Mikroformen sind stark verkleinerte Abbildungen auf Polyester-basiertem Filmmaterial, welche aufgrund ihrer Haltbarkeit von 500 Jahren, besonders gut für die Langzeitarchivierung geeignet sind. Auch ist technologische Unabhängigkeit gegeben, was die Langzeitverfügbarkeit sicherstellt. Bei der Digitalkamera halte ich es für nicht sehr relevant, zu beschreiben, wie diese genau funktioniert. Erwähnt seien jedoch die Begriffe Fokussierung, also die Anpassung der Optik an die Entfernung, Verschlusszeit, welche die Dauer der Belichtung beeinflusst, und die Größe der Blendenöffnung, welche die Schärfentiefe beeinflusst, denn diese können sowohl automatisch als auch durch den Benutzer eingestellt werden. Das andere Instrument der Bilddigitalisierung ist der Scanner. Scanner sind im Allgemeinen Geräte, die ein Objekt systematisch erfassen und in ein digitales Signal umwandeln. Für Historiker ist besonders der Bildscanner relevant. Beim Bildscanner können der Flachbettscanner und der Buchscanner unterschieden werden. Beim Flachbettscanner wird das Objekt mit der zu scannenden Seite nach unten auf eine Glasplatte gelegt, unter welcher verschiedene Spiegel das Licht zu einem Bildsensor führen. Ein Problem ist hierbei, dass, aufgrund der mangelnden Schärfentiefe, das Objekt fest auf der Glasplatte liegen muss, was z.B. bei Buchbindungen eine Schwierigkeit darstellt. Der Buchscanner hingegen ist speziell für das Scannen von Büchern spezialisiert. Hierbei wird das zu scannende Buch aufgeschlagen auf einer Buchwippe platziert und anschließend von einer Digitalkamera, welche vorher an die Lichtverhältnisse und Buchgröße angepasst werden muss, abgelichtet. Auch hier kann es zu Problemen mit dem Buchrücken kommen, denn das Buch muss bis zum einem Winkel von 180 Grad geöffnet werden. Hilfe kann hierbei der Wolfenbütteler Buchspiegel gewähren, er ermöglicht einen Öffnungswinkel von lediglich 45 Grad. Das Umblättern der einzelnen Seiten kann entweder langsam per Hand oder effektiver durch Scan-Roboter geschehen, welche die Seiten ansaugen und automatisch umblättern. Unabhängig davon, für welche Form der Bilddigitalisierung ich mich entscheide, ist es von hoher Wichtigkeit, dem Digitalisat die nötigen Parameter anzuhängen, um mögliche Fehlinterpretationen zu verhindern. Diese Parameter können sowohl Aussagen etwa darüber geben, ob die Quelle noch eine Beschriftung der Rückseite besitzt, als auch technische Parameter der Digitalisierung sein. Technische Parameter beinhalten unter anderem Informationen über die Auflösung eines Scans, also der Dichte an Bildpunkten pro Streckeneinheit. In der Regel wird die Auflösung in pixel per inch (ppi) angegeben, wobei ein höherer Wert auch eine höhere Schärfe bedeutet. Welche Auflösung für welches Objekt verwendet wird, hängt ganz vom Verwendungszweck des Digitalisats ab. Um die Betrachtung mit dem bloßen Auge zu simulieren ist etwa eine Auflösung von 300ppi ausreichend, für genauere Analysen des Objekts werden jedoch höhere Auflösungen benötigt.

Um etwa die Auffindbarkeit eines Digitalisats zu gewährleisten, müssen sogenannte Metadaten erzeugt werden. Hierbei können deskriptive, welche zum Auffinden eines Objektes herangezogen werden, strukturelle, welche verwendet werden, um das Objekt in seinem Aufbau zu erfassen, technische, welche verwendet werden, um die Qualität des Objekts zu beurteilen und administrative Metadaten, welche verwendet werden, um etwa Nutzungsrechte zu dokumentieren, unterschieden werden. Diese Trennung ist allerdings nicht strikt. Im Rahmen dieser Metadaten gibt es verschiedene internationale Standards, wie Dublin Core, METS, MODS, TEI, EAD und SAFT. Ich halte es an dieser Stelle nicht für nötig, alle Standards vorstellen, werde jedoch TEI kurz zusammenfassen, denn mit diesem Standard haben wir uns in der Spring School beschäftigt. TEI steht für Text Encoding Initiative und bietet hauptsächlich Richtlinien und XML-Schemata für das Kodieren elektronischer Texte. Auch skriptive und strukturelle Metadaten können etwa im Header angegeben werden.

Bei der Digitalisierung eines Textes stößt man schnell auf das Problem, dass beim Abbilden in einer zweidimensionalen Tabelle zwar die einzelnen Pixel, jedoch nicht ihr Bedeutungszusammenhang erfasst wird. Um dies zu gewährleisten, ist eine Transkription nötig, wobei zwischen manueller und automatischer Transkription unterschieden werden kann. Bei der manuellen Transkription wird der Text per Hand abgetippt. Um dadurch auftretende Fehler zu vermeiden, können etwa zwei Transkriptionen unabhängig voneinander angefertigt werden, welche anschließend verglichen werden. Für die automatische Transkription kommt das OCR-Verfahren (Optical Character Recognition) zur Anwendung. Das Verfahrend gliedert sich in mehrere Phasen: Die Vorverarbeitung, in welcher versucht wird die Rastergrafik für die OCR zu optimieren, die Binarisierung, in welcher das Bild in Hinter- und Vordergrund gegliedert wird, die Analyse des Layouts und die Segmentierung der Vorlage, in welcher erkannt werden soll, welche Stellen Text erhalten und in welcher das Objekt logisch strukturiert wird, die Zeichenerkennung, in welcher die Buchstaben etwa in eine Matrix eingesetzt werden, um sie mit bekannten Buchstaben zu vergleichen, und schließlich die Nachbereitung, in welcher mithilfe von z.B. Wörterbüchern versucht wird die Texterkennung zu korrigieren. Ein Qualitätskriterium für die Transkription ist die Erkennungsgenauigkeit, über welche man sich als Historiker im Vorfeld stets erkundigen sollte. Die Erkennungsgenauigkeit wird in Prozent angegeben, wobei eine Transkription als „wissenschaftlich zuverlässig“ gilt, wenn sie eine Genauigkeit von 99,95 Prozent aufweist. Je älter eine Quelle allerdings ist, desto niedriger ist häufig auch die Erkennungsgenauigkeit. Gerade bei Handschriften sollte auf die manuelle Transkription zurückgegriffen werden, auch wenn diese durch computerbasierte paläographische Hilfsmittel unterstützt werden kann.

Abschließend sollen noch drei weitere Digitalisierungsverfahren kurz vorgestellt werden. Zum einen ist die Objektdigitalisierung zu nennen. Im Gegensatz zu den bisher vorgestellten Digitalisierungsverfahren wird hierbei kein zwei- sondern ein dreidimensionaler Raum abgebildet. Dadurch wird z.B. die Tiefe der Prägung einer Münze für den Betrachter ersichtlich. Ein weiteres Verfahren ist die Multispektralfotografie. Dabei wird das Lichtspektrum nicht in die drei Bereich Rot, Grün, Blau, sondern in sogenannte Spektralbänder unterteilt, was es erlaubt, auch für das menschliche Auge nicht sichtbares Licht zu erfassen. Man damit z.B. Rückschlüsse auf die chemische Zusammensetzung des Objekts ziehen. Die Audiodigitalisierung beschäftigt sich im Gegensatz dazu, mit der Digitalisierung von vorliegenden analogen Tonaufzeichnungen. Auch eine Transkription dieser Tonaufzeichnungen ist etwa bei gesprochener Sprache möglich.

Sekundärliteratur

Rehbein, Malte: Digitalisierung. In: Fotis Jannidis, Hubertus Kohle und Malte Rehbein (Hgg.): Digital Humanities. Eine Einführung. Stuttgart 2017, S. 179-198.