Mit einer Rezension von Anton Weils Roman „Super einsam“

Das Feld der Technikphilosophie wird meistens mit einer Reflexion über Bedeutung von Technologien für das Verhältnis von Mensch und Welt in Verbdinung gebracht. Doch Technologien sind nur eine Seite der Medaille: zur Kategorie der Technik gehören zum Beispiel auch Praktiken des Herstellens, wie die technik des Schuhemachens; besondere Fertigkeiten, wie die Technik des Kopfrechnens oder der Meditation; oder auch das konkrete Agieren und Wissen des Bewirkens, wie wir es in so vielen Umgangsformen mit Dingen und anderne Menschen kennen. [1] Eine Philosophie der Technik kann folglich anhand unterschiedlichster Aspekte des menschlicher Praktiken ansetzen.

Im Folgenden möchte ich eine Reflexion über die Technik des Rezensierens im Internet vornehmen. Diese werde ich entlang einer Rezension der Rezensionsnotiz von Anton Weils Roman „Super einsam“ auf der Plattform des Magazins Perlentaucher entwickeln. Die Plattform stellt eine Meta-Einordnung der verschiedensten Rezensionen über Bücher in (Online-)Zeitungen dar, indem sie die Rezensionen dieser rezensiert. (Persönlich kann ich vor der Anschaffung eines neuen Buches einen Blick auf die Rezensionsnotitzen nur empfehlen.) Also: fangen wir an!

Besuchen wir die Vorstellung eines Buches auf Perlentaucher, wird uns ein zuerst ein Überbklick über die zentralen Eckdaten eines Buches geboten — zumindest wenn man sich nicht von den unzähligen Werbungen ablenken lässt. Wir sehen direkt, dass der Auftritt recht pragmatisch gestaltet ist. Neben den Eckdaten werden uns Optionen zum Empfehlen, Drucken, Merken aber auch Kommentieren geboten. Letzterer Aspekt veranschaulicht gut, dass es sich heirbei um eine Community handelt, die im Diskrus über Bücher (und deren Rezensionen) kollektiv Eindrücke über die Werke versammeln möchte. In dieser Hinsicht stellt die Plattform eine Art kollektiv hergestellte Hilfsstellung dar, die einer passionierten Lesendenschaft Hilfestellungen zur Orientierung auf dem (immer mehr gefluteten) Büchermarkt bieten sollen. Eine Funktion, die einst von den Rezensionen der jeweils abnonierten Zeitschriften wahrgenommen wurde. Diese Plattform beitet jedoch die Möglichkeit die individuellen Präferenzen der einzelnen Rezensent:innen einzuordnen und sie als Teil eines kulturellen Diskurses ersichtlich werden zu lassen.

Dieser Blick von Oben hat viele Vor-, aber auch viele Nachteile. Als Medium stellt die Plattform eine Instanz dar, die es uns ermöglicht, einen anderen Blick auf das Geschehen der literarsischen Szene zu werden. Es vermittelt uns nicht nur den Eindruck einer Einordnung der Diskurse: es selbst ist ein Mittel, das sich zwischen die Bücher und die Rezensent:innen stellt und den Lesenden somit einen anderen Blick auf die Bücher selbst erlaubt. Die Macht der Meinungen über literarische Werke wird durch diese Plattform den wenigen Gatekeepern der Rezensent:innen-Welt entrissen. Ja, entrissen, weil sich durch die Etablierung der Plattform — auf ihr erwähnt zu werden, kann heute als Gate zur Bekanntschaft genannt werden —, durch das Medium-Perlentaucher, die Rezensent:innen nach den Rezensionen ihrer Rezensionen aus(zu)richten (haben)! (An dieser Stelle könnte man gut die Vor- und Nachteile eines vergesellschafteten Diskursraumes erörtern, in dem die klare Position einer einzlenen Person an Gewicht verliert — doch das gehört auf ein anderes Blatt. [2])

Doch kommen wir nun zur Rezension der Rezensionsnotiz. Beginnen wir diese wieder mit einem Blick auf die Darstellung bei Perlentaucher:

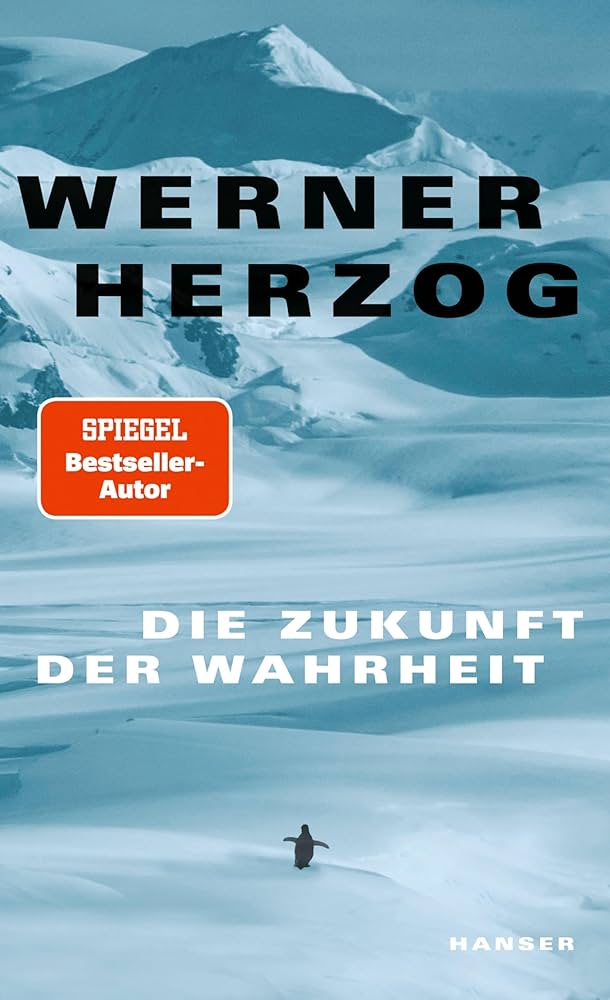

Zu dem Buch findet sich (bisher) nur eine Notiz zu der Rezension auf Deutschlandfunk Kultur. Dieses (Hörfunk-)Medium hat ein eher jüngeres Publikum, was der in der Notiz beschriebenen Thematik des Buches — das Leben als kreative, junge Person in Berlin und dessen Einsamkeit — passend ist. Ferner lesen wir, dass die rezensierte Rezensentin das Buch eher positiv bewertet, da sie es als „ungeschönt ehrlich“ und mit einer gewissen „Sogwirkung“ beschreibt. Im Zentrum des Buches stehe der „Krebstod der Mitter des Protagonisten“, welcher entlang eines „langen Bewusstseinstroms“ geschildert wird. Aus diesem Grund scheint das Buch auch in die Kategorien „Trauer und Verlust“ von „jungen“ Menschen — „Generation Y“, „Millenials“ — eingeordnet. (Der Rechtschreibfehler am Ende der Notiz veranschaulicht uns nochmals die Community-Arbeit, die offensichtlich keiner Korrekur unterliegt.)

Diese positive Notiz nahm ich als Anlass Weils Debütroman selbst zu lesen. Meine größte Erkenntis dabei war: das Medium der Veröffentlichung der rezensierten Rezension auf Perlentaucher ernster zu nehmen. Denn: es verwundert mich nicht mehr, dass Deutschlandfunk Kultur das Buch positiv bewertet. Ein Medium, das bis 2005 noch DeutschlandRadio Berlin hieß, wird autofiktionale Geschichten über das verwirrende Leben in der Hauptstadt aus guten Gründen positiv bewerten. Hier meine eigene Rezension.

Anton Weils Roman „Super einsam“ handelt von Vito, einem 30 Jahre alten, in Kreuzberg lebenden Schauspieler, dem wir nach einer Trennung einige Tage bei einer Art Sinnsuche begleiten. Vito sehnt sich nach Nähe, die ihm diverse Aspekte des Großstadtlebens in Berlin zu verwehren scheinen. Gründe hierfür findet er viele: die Gentrifizierung des eigenen Kiezes, die das Leben steril und austauschbar macht; die Oberflächlichkeit im Umgang miteinander, da alle nur nach ihrer eigenen hedonistischen Zufriedenheit streben; die Erziehung seines Vaters und dessen Konsitution von Männlichkeit, die Vito gegenüber keine Wärme zulassen kann; sowie der frühe Tod seiner Mutter. Zwischen Vitos Drogenexzessen, die er eigentlich hinter sich lassen möchte, sieht er seine einzigen Auswege aus der großstädtlichen Einsamkeit in zwei Hoffnungen: einer Reise an den französischen Atlantik oder im Beginn einer neuen romantischen Beziehung. Ersteres scheint mir eine Flucht nicht unähnlicher seiner Drogenexzesse zu sein; zweiteres ein ziemlich konservatives Ideal einer romantischen Paarbeziehung, die ihn „erlösen“ würde. Diesen Erlösungsgedanken der Paarbeziehung finde ich problematisch. Zum einen reproduziert er den von Daniel Schreiber in seinem Essay „Allein“ als „letzte große Erzählung“ unserer Gesellschaften beschriebenen Mythos der Erfüllung durch eine:n romantische:n Partner:in — was den Anderen eine erhebliche Bürde auferlegt. Zum anderen wirkt die zwischen den Zeilen entwickelte Gesellschaftskritik durch dieses Narrativ als unüberwindbar.

Weils autofiktionales Werk muss als gelungener erster Roman gesehen werden, der jedoch zu einer sehr speziellen Gruppe Menschen sprechen soll: jungen Menschen in Großstädten wie Berlin, die bei der Suche nach Sinn im Leben unzähligen Hindernissen ausgesetzt sind. Hindernisse, die zwischen den kapitalistisch-materialistischen Bedinungen, der Ablehnung der Werte vergangener Traditionen — außer dem Wert der romantischen Paarbeziehung — und der Verleitung zum Exzess zu enorm scheinen, um überwunden werden zu können.

Das Buch ist im Kein und Aber Verlag als schön-gebundene Ausgabe mit 240 Seiten für 22€ erhältlich.

Sven Thomas

Fußnoten:

[1] An dieser Stelle empfehle ich Hubigs Buch „Die Kunst des Möglichen I“. In diesem Werk entwickelt er eine Perspektive, die Technik als ein Medium versteht.

[2] Das könnte ein spannendes Hausarbeitsthema sein 😉 Ich denke zum Beispiel an Hannah Arendts in ihrer Vita activa entwickelten Analyse des Verkommens der Öffentlichkeit und Privatheit hin zu dem, was sie das Gesellschaftliche nennt; in dem es nur noch ein Sich-Verhalten gibt; in dem keine herausragende Leistung der Individuuen mehr gewürdigt wird; …