„logic is magnificent, but no guide to language” – Yorik Wilks über Margaret Masterman

In den 1950-er Jahren wurde von einer an Sprache, Philosophie und Informatik interessierten Studentengruppe aus Cambridge die CLRU, die Cambridge Language Research Unit gegründet. Die Gruppe spielte eine zentrale Rolle in der Entwicklung der maschinellen Übersetzung und viele ihrer Mitglieder wurden später zentrale Figuren in den Feldern, auf denen die moderne KI-Forschung basiert (vgl. Yorik 2000; 281 f.). Im Mittelpunkt der Forschungsgruppe stand Margaret Masterman, eine Schülerin von Ludwig Wittgenstein, die die Gruppe konzeptionell grundlegend beeinflusste, vor allem hinsichtlich des Verhältnisses von Wörtern und Bedeutungen, sowie hinsichtlich der Rolle traditioneller Sprachlogik beim Codieren.

Ihre Ansichten lassen sich mit Wittgensteins philosophischen Untersuchungen näher erläutern. Dieser widerspricht zu Beginn seines Werkes Augustinus Vorstellung einer Sprache, die zentral auf Gegenstand-Begriff-Zusammenhängen basiert. Er entwickelt ein Sprachspiel, indem ein Gehilfe einem Meister verschiedene Baumaterialien holen soll. Die Sprache der beiden besteht allein aus diesen Materialien. Wittgenstein überlegt, dass beim Nennen der Baumaterialien nicht ein Verstehen einer Begriffsbedeutung einsetzen würde, sondern allein eine Handlungsausführung. Der Gehilfe holt das verlangte Material. „Versteht nicht der den Ruf ‚Platte!‘, der so und so nach ihm handelt?“ (Wittgenstein 2003; 15). Somit sei die Bedeutung, oder eher Funktion, des Wortes durch den Kontext seiner Verwendung und seines Erlernens bestimmt.

In der traditionellen Logik vertreten Wörter Konzepte. Sie ermöglichen es, diese in Sätzen miteinander zu verbinden, wobei über allem die Frage nach dem richtig und falsch steht. Aber inwiefern kann – mit dem Wittgensteinschen Sprachspiel im Hinterkopf –denn bei einem kontextlosen Satz Wahrheit eine Rolle spielen, wenn dessen gesamte Bedeutung eigentlich vom Kontext abhängt? Natürlich zeigt sich hier auch die Differenz zwischen logischer Sprachnutzung und Alltagssprache (auch der Alltagssprache von Meister und Gehilfen), aber daraus kann wiederum die Frage abgeleitet werden, inwiefern logische Sprache auch nur in ihrem eigenen akademischen Kontext funktioniert…

Zurück zu Margaret Masterman. Sie hat sich in der CLRU die Aufgabe gestellt, die philosophischen Grundlagen der maschinellen Übersetzung von Alltagssprache aufzustellen. In ihrem frühen Aufsatz „Words“ (Masterman 1954) wird deutlich, wie ein rein logischer Ansatz hier nicht weiterkommt. Dazu nutzt sie folgendes Beispiel:

S.: It does not seem to be invariably the case that from I know that p there follows p

T.: What ? ? ? […]

Dieses Beispiel bezieht sich auf eine englische Verwendung von „know“, die wohl im Deutschen mit einem „Ich hätte schwören können, dass p“ deutlich eindeutiger wäre. Im Englischen ist allerdings der Logiker T höchst verwirrt, da für ihn Wissen eine faktische Gegebenheit voraussetzt. S. bezieht sich aber, so Masterman, auf eine untypischere, aber reale Verwendungsweise von „know“ (Vgl. Masterman 1954; 228).

Wenn eine Übersetzungsprogramm ein Wort in eine andere Sprache übertragen will, wird es mit den Bedeutungsambiguitäten der Sprache konfrontiert. „know“ ist nicht immer „wissen“, wie es ein Logiker verwenden würde. Die Bedeutung wird allerdings eindeutiger, so mehr sprachlicher Kontext vorhanden ist. Die Verwendung von „know“ im Beispiel wird klarer, wenn es beispielsweise um eine vergessliche Person geht, die nach ihrem Wohnungsschlüssel sucht. Mastermans zentrale Erkenntnis aus dem Aufsatz ist die, dass eine Bedeutungseindeutigkeit nur bei unendlich viel Kontext als vollständig eindeutig bewertet werden könne, in Mastermans Worten: „only in the case of an infnitely long sequence would zero indeterminatess be attained“ (Masterman 1954; 232).

Sowohl Wittgensteins Sprachspiele als auch Mastermans Aufsatz zeigen spannende Aspekte der alltäglichen Sprachverwendung auf. Lässt sich vielleicht etwas vom maschinellen Lernen lernen, wenn es um die Beziehung von Wörtern und Konzepten geht?

Besonders in geisteswissenschaftlichen Fächern stellen die Definition und der Diskurs um Fachwörter und ihre Definitionen einen zentralen Teil der Wissenschaftlichkeit der Fächer da. Begriffsnetze werden durch Definitionen hergestellt und auch Alltagswörter in einer ihrer vielen Facetten festgelegt, um für das Forschungsfeld den Gegenstand zu vereinheitlichen.

Oft entsteht aber auch durch diese Fachsprachen-Fokussierung eine Zugangsschwierigkeit zum Fachdiskurs, der sich dann oft auch an Definitionsdifferenzen aufhält. Wenn ein Fachbegriff durch die Kombination zweier Fachbegriffe definiert wird usw., führt die gesamte Sprachfestlegung zu einem in sich geschlossenen System, dass wenig Aussage über die Welt außerhalb sich selber treffen kann. Es ist praktisch in einem selbst produzierten sprachlichen Hamsterrad stecken geblieben.

Ich behaupte, dass die akademische Sprachverwendung durchaus etwas von den Wittgensteinschen und Mastermanschen Grundlagen der maschinellen Übersetzung lernen kann. Fachsprache basiert, wie auch logische Sprache, auf Alltagssprache. Wörter sind immer uneindeutig gegenüber Bedeutungen. Kontext, wie Beispiele, helfen beim Verständnis und lenken die unendlichen Bedeutungsmöglichkeiten in engere Bahnen.

Masterman war ebenfalls der Meinung, dass ein Thesaurus eine viel bessere Basis für maschinelles Lernen liefern würde als ein Wörterbuch (vgl. Wilks 2000; 287). In einem Wörterbuch werden Definitionen, um alphabetisch sortierte Wörter zu beschreiben. Ein Thesaurus ist wiederum nach inhaltlichen Kategorien sortiert, also nach Kontexten. Ein Computer kann nur deshalb einen Satz übersetzen, weil er es in der richtigen Kategorie wiederfindet.

Was nehme ich aus meiner Beschäftigung mit Wittgenstein und Masterman mit? Dass es sprachontologisch gar nicht so sinnvoll ist, sich mit der exakten logischen Konstruktion einer Definition auseinanderzusetzen, sondern dass ein Kontext, ein Beispiel, eine Einordnung ein viel sinnvollerer Wegweiser zum Gemeinten darstellen kann. Die Einsicht der Ambiguität von Sprache kann nicht nur Google Übersetzer helfen, sondern auch vielen akademischen Diskursen.

Von Henrik Laufer

Quellen:

Masterman, Margaret (1954): XI. – Words. In: Proceedings of the Aristotelian Society Volume 54, Issue 1, 1 Juli 1954. o.V. (S. 209-232)

Wittgenstein, Ludwig (2003): Philosophische Untersuchungen. Hg. v. Joachim Schulte. Erste Auflage. Frankfurt am Main: Suhrkamp Verlag (Bibliothek Suhrkamp Band 1372).

Wilks, Yorik (2000): Margaret Masterman. In: Early Years in Machine Translation. Hg. V.: W. John Hutchins. Amsterdam: John Benjamin B. V. (Amsterdam Studies in the Theory and History of Linguistic Science, Series III Studies in the history of language Science Volume 97).

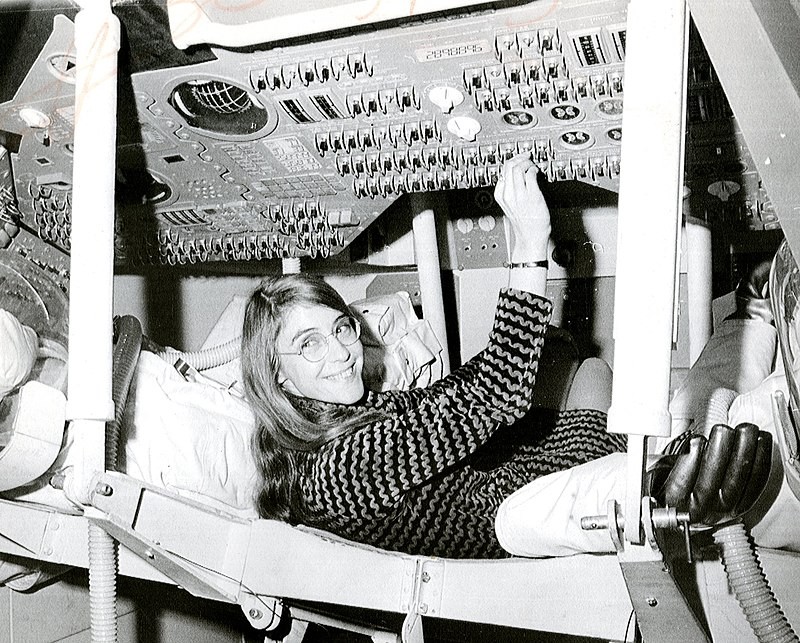

Bildquelle:

Abbildung 1: https://www.derstandard.de/story/2000104884076/margaret-hamilton-sie-schoss-die-maenner-auf-den-mond